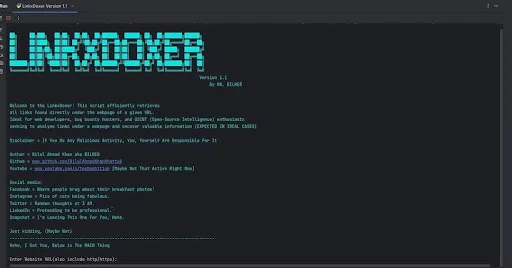

LinkxDoxer A Python script designed to efficiently retrieve all links found directly under the webpage of a given URL

Oleh

chmood

"LinkxDoxer" adalah script Python yang dirancang untuk secara efisien mengambil semua tautan yang ditemukan langsung di bawah halaman web dari URL yang diberikan.

Ini sangat ideal untuk pengembang web, pemburu bug bounty, dan penggemar OSINT (Open-Source Intelligence) yang ingin menganalisis tautan di bawah halaman web dan mengungkap informasi berharga.

Dalam kasus ideal, diharapkan untuk:

- Mengambil semua hyperlink yang ada di halaman web yang ditentukan.

- Menyediakan daftar URL yang komprehensif untuk analisis lebih lanjut.

- Membantu mengidentifikasi potensi kerentanan atau informasi berharga yang tersembunyi di halaman yang terhubung.

- Membantu dalam eksplorasi sistematis dari struktur situs web untuk tujuan pengembangan atau keamanan.

Fitur-fitur "LinkxDoxer" adalah sebagai berikut:

1. Mengambil semua tautan yang ditemukan langsung di bawah halaman web dari URL yang diberikan.

2. Mendukung URL HTTP dan HTTPS.

3. Memungkinkan penyesuaian jumlah percobaan ulang dan penundaan antar percobaan untuk menangani masalah jaringan dengan baik.

4. Memberikan pesan kesalahan yang terperinci untuk pemecahan masalah yang lebih baik.

Berikut adalah kode Python untuk "LinkxDoxer" yang mencakup fitur-fitur tersebut:

```python

import requests

from bs4 import BeautifulSoup

import time

def fetch_links(url, retries=3, delay=5):

"""

Fetch all links from a webpage.

Args:

url (str): The URL of the webpage to fetch links from.

retries (int): Number of retries in case of a request failure.

delay (int): Delay in seconds between retries.

Returns:

list: A list of retrieved links.

"""

headers = {

"User-Agent": "LinkxDoxer/1.0 (https://example.com/bot)"

}

for attempt in range(retries):

try:

response = requests.get(url, headers=headers)

response.raise_for_status() # Raise an HTTPError for bad responses

soup = BeautifulSoup(response.content, 'html.parser')

links = [a['href'] for a in soup.find_all('a', href=True)]

return links

except requests.RequestException as e:

print(f"Attempt {attempt + 1} failed: {e}")

if attempt < retries - 1:

print(f"Retrying in {delay} seconds...")

time.sleep(delay)

else:

print("All attempts failed. Exiting.")

return []

Example usage

if __name__ == "__main__":

url = "https://example.com"

links = fetch_links(url)

if links:

print("Retrieved links:")

for link in links:

print(link)

else:

print("No links retrieved.")

```

Penjelasan kode:

1. Mengambil Semua Tautan:

Fungsi `fetch_links` mengambil semua tautan dari halaman web yang diberikan URL-nya.

2. Dukungan untuk HTTP dan HTTPS:

Script mendukung URL dengan skema HTTP dan HTTPS.

3. Penyesuaian Percobaan Ulang dan Penundaan:

Parameter `retries` dan `delay` memungkinkan penyesuaian jumlah percobaan ulang dan penundaan antar percobaan.

4. Pesan Kesalahan Terperinci:

Pesan kesalahan yang terperinci dicetak untuk membantu pemecahan masalah jika terjadi kegagalan.

Proyek ini dibuat untuk tujuan pendidikan dan tidak boleh digunakan di lingkungan tanpa izin hukum.

#Unduh #Tautan: LinkxDoxer

Tautan ke artikel ini: https://www.75n1.net

Terima kasih!

Semua artikel sumber daya di situs ini dikumpulkan dan dikompilasi dari Internet. Situs ini tidak berpartisipasi dalam produksi. Jika melanggar hak dan kepentingan sah Anda, silakan hubungi situs ini dan kami akan menghapusnya tepat waktu.

Sumber daya yang dipublikasikan di situs ini berasal dari Internet, dan mungkin pengalihan lalu lintas dan informasi lainnya.

Pengguna diminta untuk tetap membuka mata untuk mengidentifikasi mereka dan menjadi pengguna dengan pendapat dan penilaian independen.

Sumber daya di situs ini hanya untuk penelitian, pembelajaran, dan komunikasi.

Jika digunakan untuk tujuan komersial, silakan beli lisensi asli, jika tidak, semua konsekuensi akan ditanggung oleh pengguna yang mengunduh.

Email kontak : [email protected]

#Metaverse #Ai #Computer Science #Artificial Intelligence #businessman #Download #technology #free dollar #business every day #motivation #cybersecurity #cybersecurityawareness #security #informationsecurity #datasecurity #hacking #threat #infosecurity #technology #cloud #computerscience #informationtechnology #social #tech #android #bugbounty #OSINT #bug

#Negara:

#Ekuador - Quito

#El Salvador - San Salvador

#Estonia - Tallinn

#Eswatini - Mbabane, Lobamba

#Fiji - Suva

#Filipina - Manila

#Finlandia - Helsinki

#Gabon - Libreville

#Gambia - Banjul

#Georgia - Tbilisi

#Ghana - Accra

#Grenada - Saint George's

#Guatemala - Kota Guatemala

#Guinea - Conakry

#Guinea-Bissau - Bissau

#Guyana - Georgetown

#Haiti - Port-au-Prince

#Honduras - Tegucigalpa

#Hongaria - Budapest

#India - New Delhi

#Indonesia - Jakarta

#Inggris - London

#Irak - Baghdad

#Iran - Tehran

#Irlandia - Dublin

#Islandia - Reykjavik

#Israel - Yerusalem

#Italia - Roma

#Jamaika - Kingston

#Jepang - Tokyo

#Jerman - Berlin

#Yaman - Sana'a

#Yordania - Amman

#Kaledonia Baru - Noumea

#Kamerun - Yaounde

#Kanada - Ottawa

#Kap Verde - Praia

#Kazakhstan - Nur-Sultan

#Kenya - Nairobi

#Kirgizstan - Bishkek

#Kiribati - Tarawa

#Kolombia - Bogota

#Komoro - Moroni

#Kongo - Brazzaville

#Kosta Rika - San Jose

#Kroasia - Zagreb

#Kuba - Havana

#Kuwait - Kuwait City

#Laos - Vientiane

#Latvia - Riga

#Lebanon - Beirut

#Lesotho - Maseru

#Liberia - Monrovia

#Libia - Tripoli

#Liechtenstein - Vaduz

#Lituania - Vilnius

#Luksemburg - Luksemburg

#Madagaskar - Antananarivo

#Maladewa - Male

#Malawi - Lilongwe

#Malaysia - Kuala Lumpur

#Mali - Bamako

#Malta - Valletta

#Maroko - Rabat

#Mauritania - Nouakchott

#Mauritius - Port Louis

#Meksiko - Mexico City

#Mesir - Kairo

#Mikronesia - Palikir

#Moldova - Chisinau

#Monako - Monako

#Mongolia - Ulan Bator

#Montenegro - Podgorica

#Mozambik - Maputo

#Myanmar (Burma) - Naypyidaw

#Namibia - Windhoek

#Nauru - Yaren

#Nepal - Kathmandu

#Niger - Niamey

#Nigeria - Abuja

#Nikaragua - Managua

#Norwegia - Oslo

#Oman - Muscat

#Pakistan - Islamabad

#Palau - Ngerulmud

#Palestina - Jerusalem

#Panama - Panama City

#Papua Nugini - Port Moresby

#Paraguay - Asuncion

#Peru - Lima

#Polandia - Warsaw

#Portugal - Lisbon

#Prancis - Paris

#Qatar - Doha

#Republik Afrika Tengah - Bangui

#Republik Ceko - Praha

#Republik Dominika - Santo Domingo

#Rumania - Bucharest

#Rusia - Moscow

#Rwanda - Kigali

#Saint Kitts dan Nevis - Basseterre

#Saint Lucia - Castries

#Saint Vincent dan Grenadines - Kingstown

#Samoa - Apia

#San Marino - San Marino

#Sao Tome dan Principe - Sao Tome

#Selandia Baru - Wellington

#Senegal - Dakar

#Serbia - Belgrade

#Seychelles - Victoria

#Sierra Leone - Freetown

#Singapura - Singapura

#Slovakia - Bratislava

#Slovenia - Ljubljana

#Solomon Islands - Honiara

#Somalia - Mogadishu

#Spanyol - Madrid

#Sri Lanka - Colombo

#Sudan - Khartoum

#Sudan Selatan - Juba

#Suriah - Damascus

#Suriname - Paramaribo

#Swedia - Stockholm

#Swiss - Bern

#Tadjikistan - Dushanbe

#Taiwan - Taipei

#Tanzania - Dodoma

#Thailand - Bangkok

#Timor Leste - Dili

#Togo - Lome

#Tonga - Nuku'alofa

#Trinidad dan Tobago - Port of Spain

#Tunisia - Tunis

#Turki - Ankara

#Turkmenistan - Ashgabat

#Tuvalu - Funafuti

#Uganda - Kampala

#Ukraina - Kiev

#Uni Emirat Arab - Abu Dhabi

#Uruguay - Montevideo

#Uzbekistan - Tashkent

#Vanuatu - Port Vila

#Venezuela - Caracas

#Vietnam - Hanoi

#Yordania - Amman

#Yunani - Athena

#Zambia - Lusaka

#Zimbabwe - Harare

#Kosovo - Pristina

#Timor-Leste - Dili

#Negara Federasi Mikronesia - Palikir

#Palau - Ngerulmud

#Sahrawi Arab Democratic Republic - El Aaiun

#Kepulauan Marshall - Majuro

#Vatikan - Vatikan City

#Kepulauan Solomon - Honiara

#Kiribati - Tarawa

#Nauru - Yaren

#Samoa - Apia

#Tonga - Nuku'alofa

تعليقات